AI教程

三分钟打造本地AI知识库!免费且无限制!

- 2024-07-16

- Arjun

- 本站原创

想象一下,一个不会记录你的个人数据信息,且没有使用限制的AI大模型,你会心动吗?关注我,我来手把手教你如何把大语言模型部署到本地,不需要网络,让你在飞机高铁上,也能愉快地用AI,效率百倍。

你想要使用AI,却又不想自己的个人信息数据被别人记住?想在飞机高铁这种无网络的环境上也能用AI来高效办公?给我一个关注,我手把手教你如何把AI大语言模型部署到本地,回答飞快,保护隐私,无需网络,而且还有没使用限制哦!

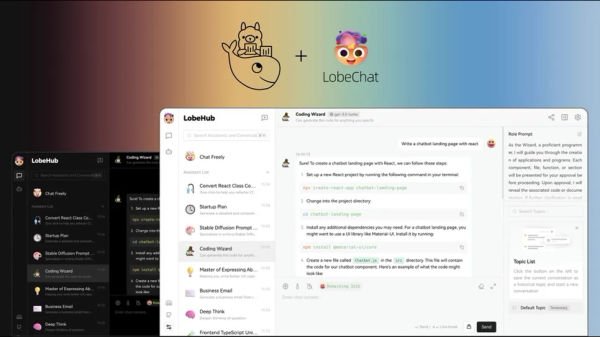

今天,我们要用到的Ollama+docker+LobeChat

帮你在电脑上,落地一个超高颜值的AI对话模型,不要被这些英文吓到,本次教程面向纯小白,即便你完全不懂代码,也没有问题。

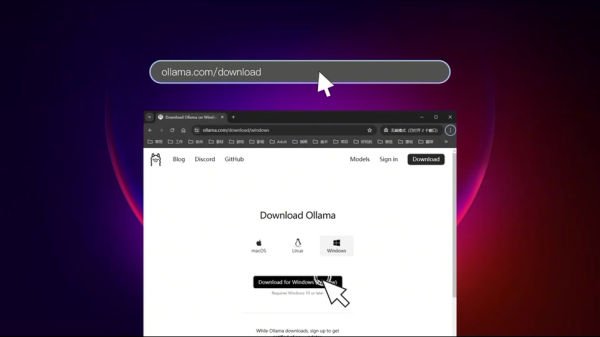

第一步、环境安装

打开屏幕中间的网址「ollama.com/download」,根据你的操作系统,选择一个客户端下载并完成ollama的安装。

安装完成后,ollama会自动运行,你可以在系统的右下角的托盘区域找到它,我们右键Quit将其关闭,因为ollama会默认将模型下载到C盘。

使用快捷「Win+R」呼出运行窗口,输入「sysdm.cpl」打开「系统属性」面板,切换到高级tab,选择环境变量。新建一个系统变量,将其命名为「OLLAMA_MODELS」,第二栏设置模型的存放目录,推荐设置在SSD固态硬盘上,可以有效的提升模型的应答速度。

接着使用快捷键「Win+Q」并输入ollama并运行。

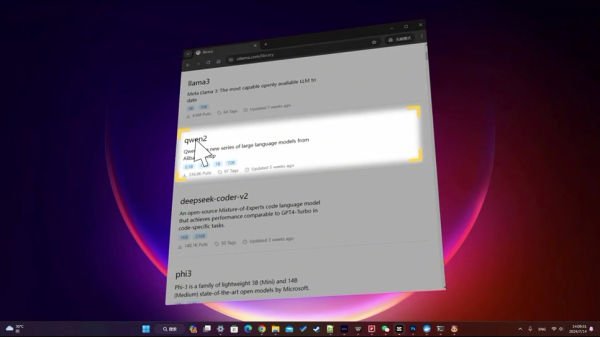

回到ollama的官网,选择Models,模型市场,这里有各大知名的开源大模型可以选择,在此我们选择阿里的通义千问2来作为演示。

下拉选择一个模型版本,注意:

如果你的电脑内存(RAM)<8G,请选择0.5B和1.5B;

8G以上,选择7B;

而72B,则至少需要64G以上的内存。

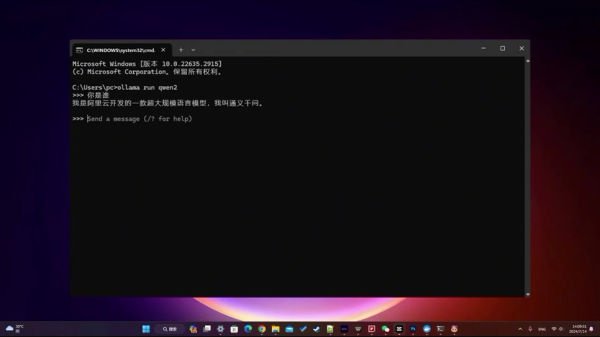

回到页面复制右侧的代码,按Win+R,输入cmd,打开命令提示符窗口,粘贴发送代码,ollama便会开始下载模型。

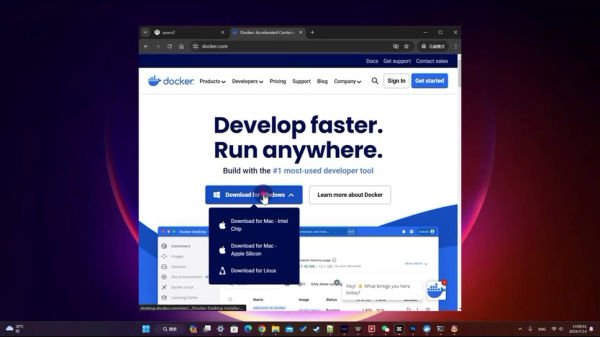

在下载的过程中,我们来进行Docker的安装,浏览器中打开「docker.com」,下载客户端并安装。

通义7b下完了,我们可以在命令行内直接和AI进行对话。可以看到,因为是本地部署,响应速度是非常快的。

第二步、LobeChat安装

本节教程要讲的,当然不是教你怎么在这样一个黑底白字的鬼地方和AI对话,而是承诺要给你一个超高颜值的对话AI。

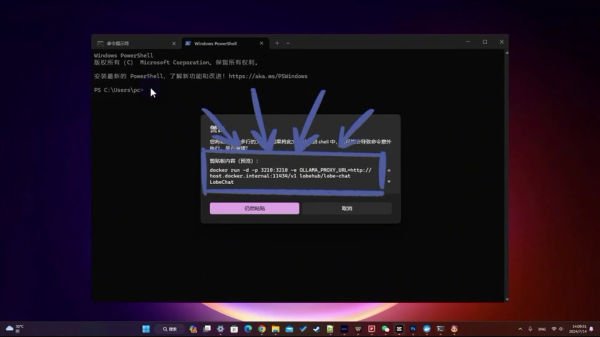

我们再次返回到命令行窗口,发送屏幕上的这段代码:

docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat

LobeChat就装好了,对,就是这么神奇。

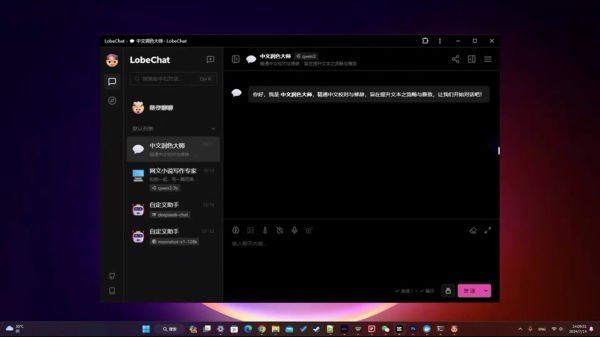

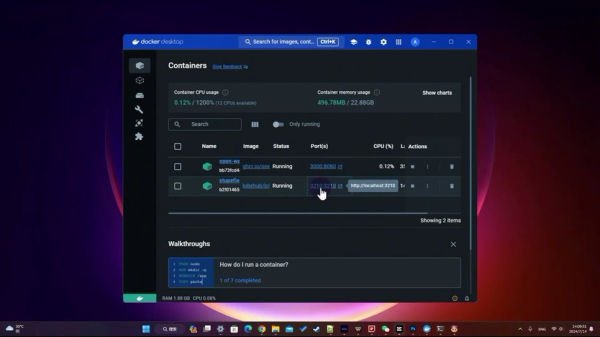

我们打开docker的主界面,找到ports端口这列,点击端口的链接,就会在你的浏览器打开LobeChat的WebUI。

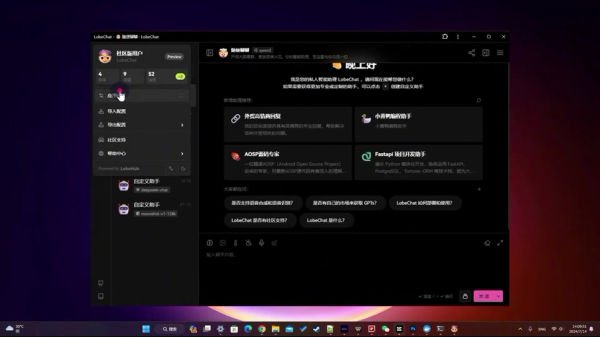

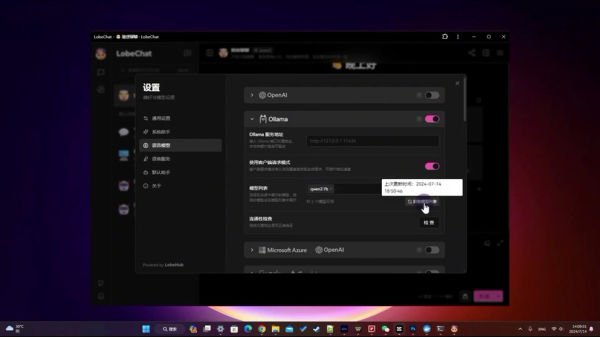

轻点左上角的头像,选择应用设置,找到「语言模型」选项,打开ollama菜单,轻点「获取模型列表」按钮,LobeChat会自动获取ollama下载完成,并曝露给我们的大模型接口。

选中千问2 7B,并检查模型的连通性。OK,关闭窗口。

在LobeChat界面新建一个对话,将模型切换为通义千问,你就可以在本地愉快的和AI进行对话了。

你还可以自定义每个对话,为其设定头像/名称/标签,以及Prompt提示词,摇身一变成为一个网文小说写作专家,让它帮你写网络小说文学。

你还可以在模型设置界面,通过输入模型的api接口,来使用包括ChatGPT、kimi、Gemini等各大品牌的大语言模型。

好了,本期视频就到此位置了,如果你有使用上的问题,欢迎讨论。